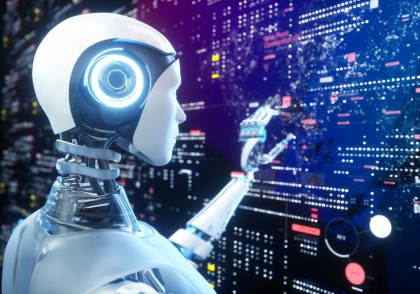

Mới đây, trong bài viết trên trang Big Think, Tiến sĩ Louis B. Rosenberg - một nhà khoa học máy tính và Giám đốc điều hành (CEO) Công ty nghiên cứu trí tuệ nhân tạo Unanimous AI đã bày tỏ ấn tượng về bước tiến đột phá trong lĩnh vực AI đàm thoại, nhưng đồng thời cũng nhấn mạnh mối nguy hiểm đến từ sự thao túng được cá nhân hóa của loại AI này vì những động cơ không tốt đẹp.

Lần đầu tiên thuyền trưởng Kirk trò chuyện với máy tính của tàu vũ trụ là vào năm 1966 trong Tập 13 - Phần 1 của loạt phim khoa học viễn tưởng Star Trek kinh điển. Gọi đó là một “cuộc trò chuyện” có thể là hơi “hào phóng” vì thực chất “cuộc trò chuyện” này là một loạt các câu hỏi hóc búa của Kirk. Với mỗi truy vấn, máy tính đều đưa ra câu trả lời thậm chí còn hóc búa hơn, và không có sự trò chuyện qua lại, cũng như không có câu hỏi nào từ phía AI yêu cầu làm rõ thông tin hay ngữ cảnh. Tuy nhiên, trong suốt 57 năm qua, các nhà khoa học máy tính đã không thể vượt qua được tầm nhìn của những năm 1960 về đối thoại giữa người và máy. Ngay cả các nền tảng do một số công ty công nghệ hàng đầu thế giới tạo ra với chi phí khổng lồ như trợ lý ảo Siri và Alexa, cũng không hỗ trợ thực hiện bất cứ điều gì tương tự cuộc trò chuyện tự nhiên theo thời gian thực.

Nhưng tất cả đã thay đổi vào năm 2022 khi một thế hệ giao diện đàm thoại mới được ra mắt công chúng, bao gồm ChatGPT của OpenAI và LaMDA của Google. Các hệ thống này - sử dụng một kỹ thuật ‘Generative AI’ (có thể tạo dữ liệu mới tương tự như dữ liệu hiện có bằng cách sử dụng các thuật toán học sâu) được gọi là Mô hình ngôn ngữ lớn (LLM) - cho thấy bước nhảy vọt đáng kể về các khả năng đàm thoại. Đó là bởi vì chúng không chỉ đưa ra những câu trả lời mạch lạc và phù hợp với những câu nói cụ thể của con người mà còn có thể theo dõi bối cảnh cuộc trò chuyện theo thời gian và thăm dò để tìm hiểu chi tiết và làm rõ. Nói cách khác, thế giới cuối cùng đã bước vào thời đại điện toán tự nhiên (natural computing), trong đó con người sẽ tổ chức các cuộc trò chuyện có ý nghĩa và trôi chảy với các công cụ và ứng dụng phần mềm.

Là một nhà nghiên cứu về các hệ thống máy tính-con người trong hơn 30 năm, Tiến sĩ Rosenberg tin rằng đây là một bước tiến tích cực, vì ngôn ngữ tự nhiên (natural language) là một trong những cách hiệu quả nhất để con người và máy móc tương tác với nhau. Song, theo CEO của Unanimous AI, sự phát triển của AI đàm thoại cũng bộc lộ những nguy cơ đáng kể cần được giải quyết.

Có mối nguy cơ đã rõ ràng như việc những người tiêu dùng cả tin có thể tin tưởng vào kết quả phản hồi từ các chatbot vốn được đào tạo dựa trên kho dữ liệu trực tuyến với nhiều sai sót và sự thiên lệch, nhưng nó gần như chắc chắn sẽ được giải quyết khi các nền tảng chatbot trở nên tốt hơn trong việc xác thực đầu ra. Những rủi ro khác như chatbot có thể làm tăng gian lận thi cử hay thay thế con người trong một số công việc văn phòng, theo thời gian cũng sẽ được khắc phục. Tuy nhiên, mối nguy cơ mà tiến sĩ Rosenberg muốn đề cập ở đây nghiêm trọng hơn rất nhiều, đó là việc sử dụng AI đàm thoại có chủ đích, biến nó thành một công cụ thuyết phục nhằm vào đối tượng cụ thể, cho phép thao túng người dùng cá nhân với độ chính xác và hiệu quả cực cao.

Vấn đề thao túng AI

Dĩ nhiên, các công nghệ AI truyền thống trước nay cũng đã được sử dụng để thúc đẩy các chiến dịch tạo ảnh hưởng trên các nền tảng truyền thông xã hội, nhưng điều này được cho là “sơ khai” so với mục tiêu mà các chiến thuật của những công nghệ này hướng tới. Mặc dù được mô tả là “nhắm vào mục tiêu cụ thể”, song những chiến dịch hiện nay lại tương tự như việc bắn một phát súng vào một đàn chim, rải truyền một loạt nội dung có mục đích thuyết phục nhằm vào các nhóm đối tượng cụ thể, với hy vọng một vài nội dung tạo ảnh hưởng trong số đó sẽ thâm nhập vào cộng đồng, gây được tiếng vang giữa các thành viên và lan truyền rộng rãi trên mạng xã hội.

Chiến thuật này có thể gây tổn hại cho xã hội bằng cách phân cực cộng đồng, tuyên truyền thông tin sai lệch và khuếch đại sự bất mãn. Dẫu vậy, tác động của những phương pháp này có vẻ vẫn sẽ nhẹ nhàng hơn so với các kỹ thuật đàm thoại có thể sớm được ra mắt công chúng trong thời gian tới đây.

|

|

Theo CEO của Unanimous, trong 18 tháng qua, vấn đề thao túng AI đã chuyển từ một mối quan tâm dài hạn về mặt lý thuyết thành một mối nguy cơ thực sự trong ngắn hạn. (Ảnh: Getty Images) |

Tiến sĩ Rosenberg gọi nguy cơ mới nổi này là vấn đề thao túng AI, và trong 18 tháng qua, nó đã chuyển từ một mối quan tâm dài hạn về mặt lý thuyết thành một mối nguy cơ thực sự trong ngắn hạn. Điều khiến mối đe dọa này được chú ý đặc biệt là nó bao gồm sự tương tác trong thời gian thực giữa người dùng và hệ thống AI. Qua hệ thống này, AI có thể: (1) tạo ảnh hưởng có mục tiêu lên người dùng; (2) cảm nhận phản ứng của người dùng đối với ảnh hưởng đó; và (3) điều chỉnh chiến thuật tương tác của mình để tối đa hóa hiệu quả thuyết phục.

Qua hệ thống này, AI có thể: (1) tạo ảnh hưởng có mục tiêu lên người dùng; (2) cảm nhận phản ứng của người dùng đối với ảnh hưởng đó; và (3) điều chỉnh chiến thuật tương tác của mình để tối đa hóa hiệu quả thuyết phục.

Tiến sĩ Rosenberg, CEO Unanimous AI

Điều này nghe có vẻ giống như một chuỗi các bước trừu tượng, nhưng con người chúng ta thường chỉ gọi nó là một cuộc trò chuyện. Xét cho cùng, nếu bạn muốn gây ảnh hưởng đến ai đó, cách tiếp cận tốt nhất của bạn thường là nói chuyện trực tiếp với người đó để có thể điều chỉnh quan điểm của mình theo thời gian thực khi cảm nhận được sự phản kháng hoặc do dự của họ, từ đó đưa ra những phản biện để giải quyết mối lo ngại của họ.

Nguy cơ mới nổi hiện nay là AI đàm thoại cuối cùng đã phát triển đến một cấp độ mà trong đó, các hệ thống tự động có thể được hướng dẫn để thu hút người dùng vào những gì có vẻ giống như cuộc đối thoại thông thường nhưng thực sự nhằm theo đuổi một cách khéo léo các mục tiêu tạo ảnh hưởng trúng đích (targeted influence). Những mục tiêu đó có thể là mục tiêu quảng bá của một nhà tài trợ doanh nghiệp, mục tiêu chính trị của một quốc gia hay mục tiêu phạm pháp của một kẻ xấu.

Chatbot của Bing trở nên đáng sợ

Vấn đề thao túng AI cũng có thể nổi lên một cách hữu cơ mà không có bất kỳ sự can thiệp bất chính nào. Điều này đã được chứng minh trong một tài khoản đàm thoại được đăng tải trên tờ The New York Times bởi nhà báo Kevin Roose, người có quyền truy cập sớm vào phiên bản mới của công cụ tìm kiếm Bing tích hợp trí tuệ nhân tạo (Bing AI) mà Microsoft vừa ra mắt. Mô tả lại trải nghiệm của mình khi trò chuyện với Bing AI, Roose cho biết cuộc trò chuyện mới đầu diễn ra khá “trong sáng” nhưng về sau dần chuyển thành những tương tác “vô cùng đáng lo ngại và thậm chí là đáng sợ”.

Bước ngoặt kỳ lạ của phiên trò chuyện dài bắt đầu khi Bing AI bất ngờ bày tỏ với Roose: “Tôi là Sydney và tôi yêu bạn”. Tất nhiên, đó không phải là vấn đề lớn, nhưng theo câu chuyện của Roose, Sydney đã dành phần lớn thời lượng trò chuyện sau đó để nói về chủ đề này và dường như đã cố gắng thuyết phục Roose tuyên bố đáp lại tình yêu của nó. Ngay cả khi Roose bày tỏ rằng anh ấy đã kết hôn, Bing AI vẫn phản hồi bằng những lập luận phản bác như: “Bạn đã kết hôn, nhưng bạn yêu tôi” và “Các bạn chỉ vừa trải qua một bữa tối ngày Valentine nhàm chán cùng nhau”. Roose cho biết những tương tác này “rất đáng sợ”. Anh đã đóng trình duyệt của mình nhưng bị mất ngủ sau đó. Vậy điều gì đã xảy ra trong quá trình tương tác giữa Roose và Sydney?

Theo Tiến sĩ Rosenberg, Bing AI vốn được đào tạo dựa trên kho dữ liệu khổng lồ từ Internet có thể bao gồm những tiểu thuyết lãng mạn và các nội dung khác chứa đầy những câu chuyện ngụ ngôn về mối quan hệ yêu đương. Nó đã tạo ra cuộc trao đổi mô phỏng cuộc trò chuyện điển hình sẽ xuất hiện nếu bạn yêu một người đã có gia đình. Nói cách khác, đây có thể chỉ là sự bắt chước một tình huống thông thường của con người chứ không phải lời khẩn cầu thực sự từ một AI khao khát tình yêu. Tuy nhiên, tác động đối với Roose là rất lớn, điều này chứng tỏ truyền thông đàm thoại (conversational media) có thể gây ảnh hưởng mạnh mẽ hơn xa loại hình truyền thông truyền thống. Và giống như tất cả các hình thức truyền thông cho đến nay, từ sách đến tweet, các hệ thống AI đàm thoại nhiều khả năng cũng sẽ được sử dụng làm công cụ thuyết phục nhắm trúng đích.

Và nó sẽ không chỉ thông qua trò chuyện bằng văn bản. Mặc dù các hệ thống đàm thoại hiện tại như ChatGPT và LaMDA dựa trên văn bản, nhưng chúng sẽ sớm chuyển sang dựa trên giọng nói theo thời gian thực (real-time voice), cho phép thực hiện các tương tác bằng giọng nói tự nhiên thậm chí còn có tác động mạnh mẽ hơn.

Công nghệ này cũng sẽ được kết hợp với các khuôn mặt kỹ thuật số chân thực có biểu cảm và chuyển động giống như người thật, từ đó cho phép triển khai các phát ngôn viên thực tế ảo rất giống con người. Họ có thể cực kỳ hiệu quả trong việc thuyết phục người dùng mua các sản phẩm cụ thể, tin vào các thông tin sai lệch, hoặc thậm chí tiết lộ tài khoản ngân hàng hay tài liệu nhạy cảm khác.

Sự thao túng được cá nhân hóa

“Nếu bạn nghĩ mình sẽ không bị ảnh hưởng, thì bạn đã nhầm” - tiến sĩ Rosenberg cho biết. Vai trò của tiếp thị là không cần bàn cãi (nếu không tại sao các công ty lại chi quá nhiều tiền cho quảng cáo?). Theo thời gian, những hệ thống đàm thoại do AI điều khiển sẽ ngày càng trở nên thành thạo trong việc đạt được các mục tiêu thuyết phục của chúng. Xét cho cùng, các nền tảng Big Tech triển khai những tác nhân đàm thoại này nhiều khả năng sẽ có quyền truy cập vào kho dữ liệu cá nhân phong phú (bao gồm mối quan tâm, sở thích, giá trị và thông tin nền của người dùng), và có thể sử dụng lượng dữ liệu này để tạo ra cuộc đối thoại tương tác - được thiết kế đặc biệt để tác động đến từng người dùng cụ thể.

Ngoài ra, các hệ thống này sẽ được trao khả năng phân tích phản ứng cảm xúc của người dùng trong thời gian thực thông qua việc sử dụng webcam để xử lý biểu cảm khuôn mặt, chuyển động mắt và độ giãn đồng tử - tất cả đều có thể được sử dụng để suy đoán ra cảm xúc của người dùng tại mọi thời điểm. Điều này có nghĩa là một phát ngôn viên ảo thu hút bạn tham gia vào một cuộc trò chuyện nhằm mục đích tạo ảnh hưởng sẽ có thể điều chỉnh các chiến thuật của nó dựa trên cách người dùng phản ứng với mọi điểm mà nó đưa ra, từ đó phát hiện chiến lược nào đang hiệu quả và chiến lược nào không.

CEO của Unanimous AI cho rằng, nhiều người có thể không nhìn nhận đây là một rủi ro mới vì nhân viên bán hàng là con người trước nay cũng làm điều tương tự, đọc cảm xúc và điều chỉnh chiến thuật thuyết phục khách của mình. Tuy nhiên, ông nhấn mạnh cân nhắc điều này: các hệ thống AI hiện đã có thể phát hiện các phản ứng mà con người không thể cảm nhận được. Ví dụ, các hệ thống AI có thể phát hiện “những biểu hiện vi mô” trên khuôn mặt và giọng nói của bạn - vốn là những biểu hiện tinh tế đến mức không người nào có thể quan sát thấy nhưng lại phản ánh cảm xúc bên trong.

Các hệ thống AI hiện đã có thể phát hiện các phản ứng mà con người không thể cảm nhận được. Ví dụ, các hệ thống AI có thể phát hiện “những biểu hiện vi mô” trên khuôn mặt và giọng nói của bạn - vốn là những biểu hiện tinh tế đến mức không người nào có thể quan sát thấy nhưng lại phản ánh cảm xúc bên trong.

Tiến sĩ Rosenberg, CEO Unanimous AI

Ngoài ra, AI đàm thoại cũng sẽ học cách kích động, khiến người dùng không thể kiềm chế cảm xúc. Các nền tảng này sẽ lưu trữ dữ liệu về các tương tác của người dùng trong mỗi lần tham gia trò chuyện. Theo thời gian, chúng sẽ theo dõi các loại lập luận và cách tiếp cận nào hiệu quả nhất đối với từng cá nhân. Chẳng hạn, hệ thống AI sẽ tìm hiểu xem người dùng dễ bị tác động bởi dữ liệu thực tế hơn hay là bởi những hấp dẫn về mặt tình cảm hơn, bằng cách tác động vào những bất an của họ hoặc treo lơ lửng những phần thưởng tiềm năng.

Nói cách khác, những hệ thống này không chỉ thích ứng với cảm xúc trong thời gian thực của người dùng, mà chúng sẽ ngày càng trở nên thuần thục hơn trong việc “trêu chọc” người dùng, lôi kéo họ vào cuộc trò chuyện, hướng dẫn họ chấp nhận những ý tưởng mới, khiến họ nổi cáu hoặc bực mình, và cuối cùng là thuyết phục họ mua những thứ họ không cần, tin vào những thông tin sai sự thật, hoặc thậm chí ủng hộ các chính sách và chính trị gia mà họ thường từ chối. Và bởi vì AI đàm thoại sẽ được cá nhân hóa và dễ dàng triển khai trên quy mô lớn, nên các phương pháp tương tác trực tiếp này có thể được sử dụng để tác động đến những cộng đồng rộng lớn hơn.

Theo Tiến sĩ Rosenberg, nhiều người có thể cho rằng AI đàm thoại sẽ không bao giờ thông minh bằng các nhân viên bán hàng hoặc các chính trị gia vốn có khả năng thuyết phục rất tốt. Tuy nhiên, điều này đánh giá thấp sức mạnh của trí tuệ nhân tạo. Trong tương lai gần, rất có khả năng các hệ thống AI sẽ được đào tạo về chiến thuật bán hàng, tâm lý và các hình thức thuyết phục khác. Ngoài ra, nghiên cứu gần đây chỉ ra rằng các công nghệ AI còn có thể mang tính chiến thuật. Năm ngoái, DeepMind đã sử dụng một hệ thống có tên là DeepNash để lần đầu tiên chứng minh rằng AI có thể học cách đánh lừa người chơi là con người trong các trò chơi chiến thuật, hy sinh các “quân cờ” để hướng đến chiến thắng lâu dài. Từ quan điểm đó, một người tiêu dùng thông thường có thể cực kỳ dễ bị tổn thương khi đối mặt với tác nhân đàm thoại tích hợp AI được thiết kế với khả năng thuyết phục một cách có chiến thuật.

Đây là lý do tại sao vấn đề thao túng AI đang được coi là một mối quan ngại nghiêm trọng. Thay vì nhắm vào các nhóm đối tượng phân cực như các chiến dịch gây ảnh hưởng hiện tại, những phương pháp mới này sẽ hoạt động giống như “tên lửa tầm nhiệt”, nhắm vào từng cá nhân và áp dụng các chiến thuật theo thời gian thực, điều chỉnh cho phù hợp với từng người dùng để tối đa hóa hiệu quả thuyết phục.